Chute des impressions GSC depuis septembre : une question de mesure, pas de performance

La chute brutale des impressions observée dans Google Search Console depuis le 11 septembre 2025 n’a rien d’une pénalité. Il ne s’agit ni d’un effondrement SEO, ni d’un recul de visibilité. Ce phénomène s’explique par un ajustement technique : la désactivation du paramètre &num=100, historiquement utilisé pour afficher 100 résultats par page dans les SERP.

Le paramètre &num=100 : disparition silencieuse mais impact massif

Le 11 septembre, Google a supprimé discrètement la possibilité d’ajouter &num=100 dans les URL de recherche. Ce petit paramètre, pourtant anodin en apparence, était utilisé intensivement par les outils SEO pour récupérer les classements jusqu’à la 100e position.

Résultat immédiat : là où une seule requête permettait de charger 100 résultats et donc 100 impressions en GSC, il faut désormais 10 requêtes distinctes. Les impressions “techniques” disparaissent, et les données GSC retrouvent un périmètre plus proche de l’expérience utilisateur réelle.

Les bots SEO et scrapers comme générateurs artificiels d’impressions

Les outils de suivi de position (SEMrush, Ahrefs…) s’appuyaient sur &num=100 pour extraire massivement des données de classement. Chaque requête envoyée par leurs bots générait mécaniquement 100 impressions, même pour des résultats situés en bas de SERP, jamais vus par les internautes.

Les impressions fantômes ainsi générées concernaient particulièrement :

- Les positions 11 à 100 (au-delà de la première page)

- Le trafic desktop (environnement privilégié des scrapers)

- Les requêtes longue traîne à faible visibilité réelle

En supprimant ce paramètre, Google a tarit une source massive de faux signaux d’exposition.

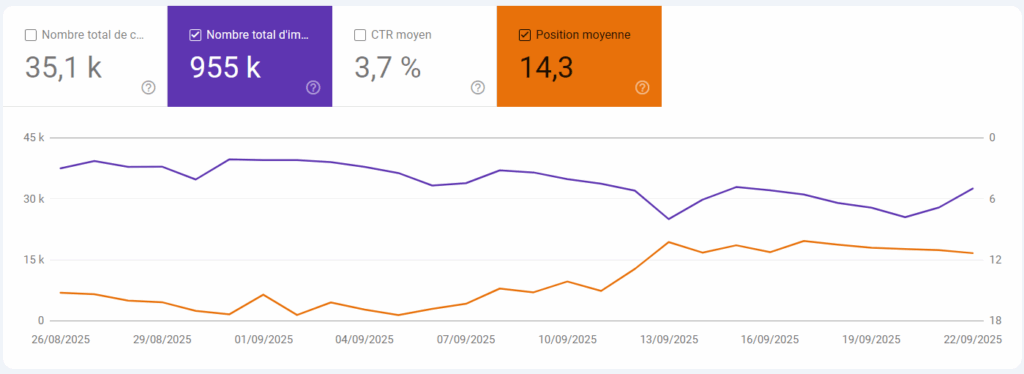

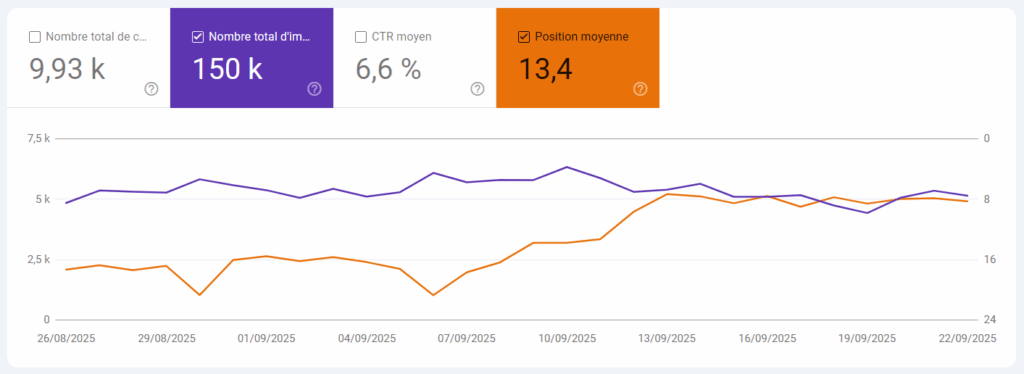

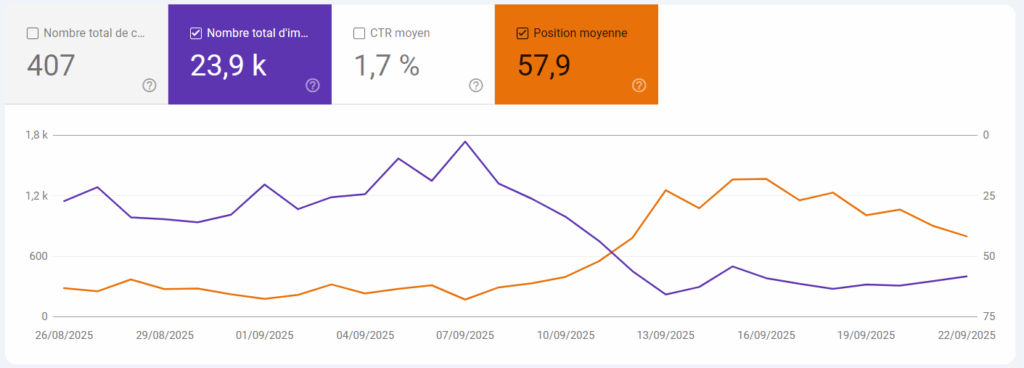

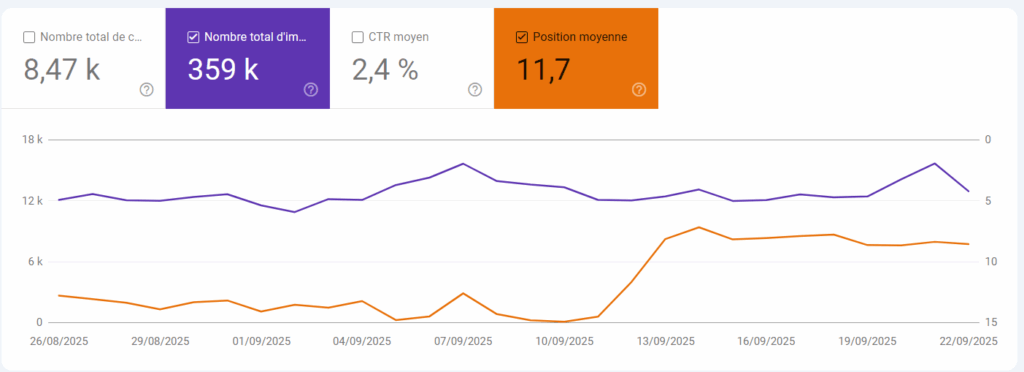

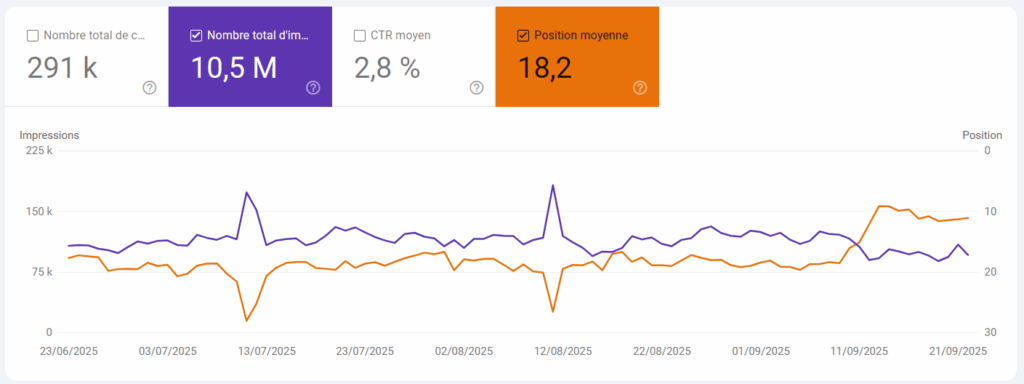

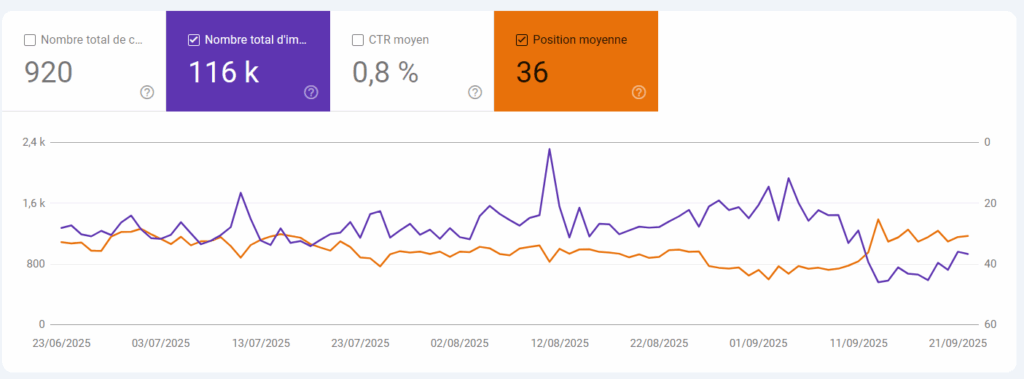

Des symptômes typiques, visibles dès le 11 septembre

Les webmasters et consultants SEO ont rapidement identifié un pattern récurrent :

- Chute massive des impressions (De -5 % à 90% dans certains cas)

- Amélioration apparente de la position moyenne

- Stabilité des clics et du trafic réel

- Impact quasi exclusivement sur le desktop

Le diagnostic est clair : il s’agit d’un nettoyage méthodologique, pas d’une sanction.

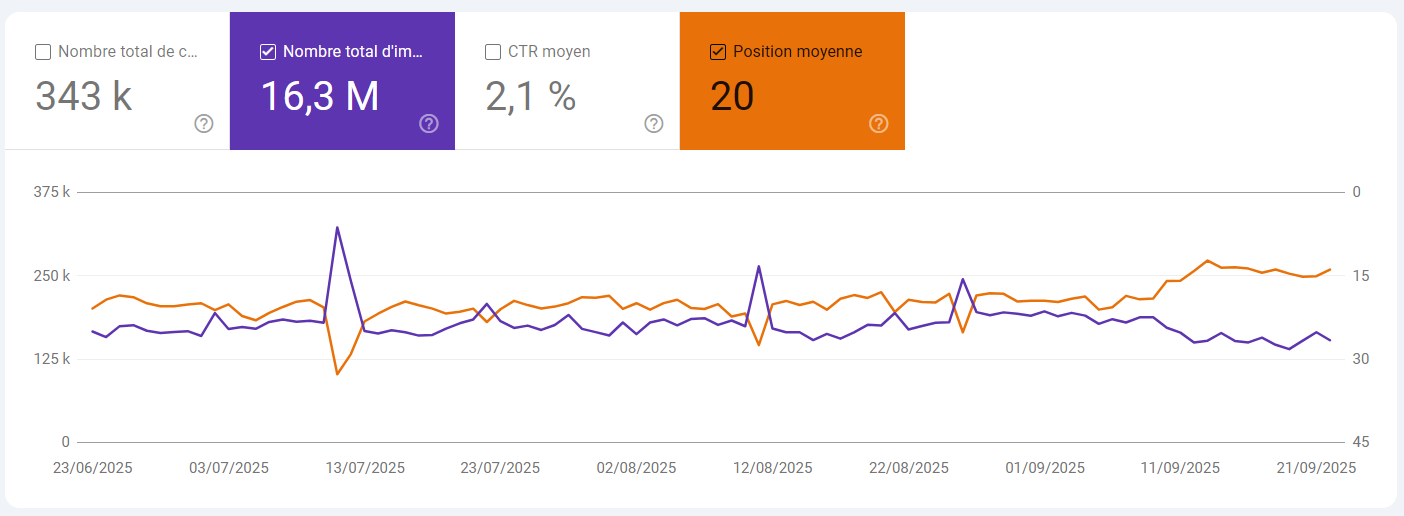

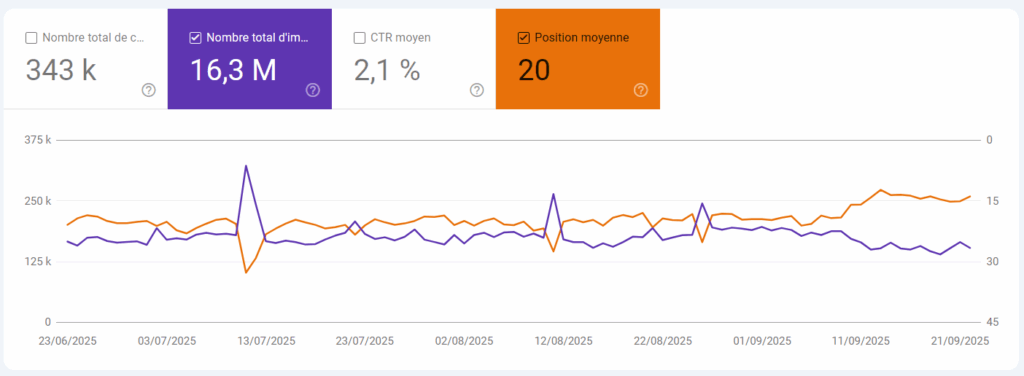

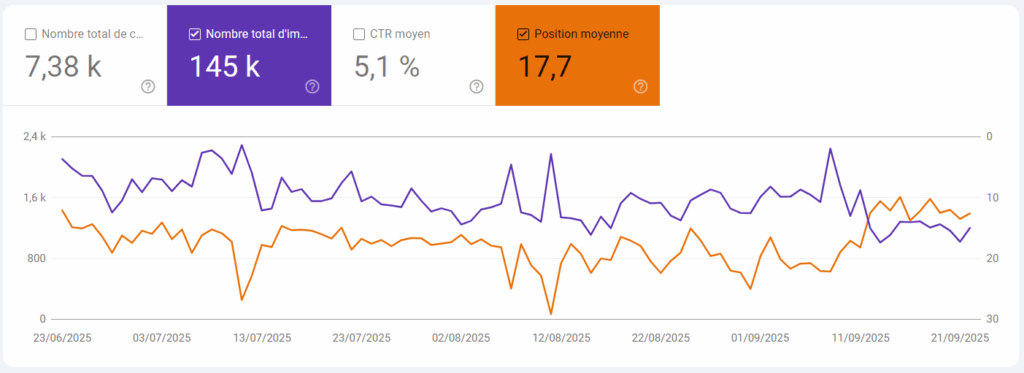

Ci-dessous : Quelques exemples extraits de la GSC

La théorie du “Great Decoupling” remise en cause

Depuis juillet 2025, de nombreux observateurs voyaient dans l’explosion des impressions un effet collatéral des AI Overviews. Cette théorie, surnommée “Great Decoupling”, décrivait une dissociation croissante entre impressions en hausse et clics en baisse.

L’hypothèse vacille : une partie de cette hausse pourrait provenir de l’intensification du scraping par les outils SEO et les IA génératives. Le lien entre hausse des impressions et changement d’UX Google est donc à relativiser.

Des conséquences directes pour les outils de suivi de position

La suppression du paramètre &num=100 impacte fortement les plateformes de suivi de positionnement comme SEMrush, Ahrefs, Sistrix ou SE Ranking. Jusqu’ici, une seule requête permettait de récupérer les positions 1 à 100 pour un mot-clé donné. Désormais, il faut effectuer dix requêtes distinctes pour obtenir le même volume d’information.

Cette modification entraîne une augmentation mécanique :

- Du nombre de requêtes nécessaires par analyse

- De la charge sur les infrastructures techniques (CPU, bande passante, API)

- Des délais de collecte, notamment sur les gros volumes de mots-clés

Le coût unitaire par suivi augmente donc sensiblement. La conséquence est prévisible : ces surcoûts techniques seront en grande partie répercutés sur les clients finaux. Les éditeurs d’outils n’auront d’autre choix que d’augmenter les tarifs ou de restreindre le volume de données disponibles dans les offres standards.

À court terme, cela pourrait pousser certains acteurs à :

- Revoir leur modèle de tarification par paliers

- Réduire la fréquence de suivi sur les positions profondes

- Introduire des limitations d’accès à certaines métriques

Pour les agences et annonceurs, il devient vital de reprioriser les KPIs réellement utiles et d’ajuster les reportings aux nouveaux standards de mesure.

Pourquoi Google a-t-il procédé à ce changement ?

Plusieurs motivations techniques et stratégiques sont possibles à mon avis :

- Réduire l’exploitation abusive des résultats par les scrapers et IA

- Améliorer la fiabilité des données GSC en supprimant les signaux parasites

- Limiter les coûts serveurs liés aux requêtes massives automatisées

- Fournir aux éditeurs de sites des métriques plus représentatives

Que faire face à cette nouvelle donne ?

Ne pas surinterpréter la chute

Les clics n’ont pas chuté. Le trafic réel est stable. Il n’y a donc aucun motif d’alerte opérationnelle. Ce changement est une correction de mesure, pas une dégradation de performance.

Recalibrer vos benchmarks

Prenez septembre 2025 comme nouveau point de référence. Toute analyse de performance basée sur les impressions doit être contextualisée à la lumière de cette modification structurelle.

Concrètement :

- Privilégier l’analyse des clics plutôt que des impressions

- Appuyer vos constats sur Google Analytics pour valider les tendances

- Documenter ce changement dans vos rapports pour éviter toute confusion

Expliquer en interne

Cette évolution peut dérouter les équipes marketing ou les clients. Il est essentiel de leur expliquer que la baisse des impressions est une correction technique, et non un recul SEO.

Les autres signaux de septembre 2025

En parallèle de cette correction, d’autres mouvements ont pu générer de la volatilité dans les SERP :

- La clôture de l’August 2025 Spam Update le 22 septembre

- Le déploiement de nouvelles fonctionnalités AI Overviews

- Des ajustements algorithmiques autour du E-E-A-T

- Sans doute une baisse du poids de navboost durant cette période

Toutefois, ces évolutions ne sont pas responsables de la chute brutale d’impressions observée. Le facteur déterminant reste bien la suppression du paramètre &num=100.

Note méthodologique

La Search Console ne mesure pas la performance, elle mesure l’exposition. Et l’exposition dépend toujours de la manière dont Google structure ses pages.

Ce changement rappelle un principe fondamental : les données GSC reflètent un mode de collecte, pas un trafic réel. Lorsqu’un paramètre structurant est supprimé, les métriques changent, parfois sans qu’aucun comportement utilisateur n’ait évolué.